Ngày nay bạn truy cập Google, xem video trên YouTube, dùng Facebook, chạy ứng dụng trên AWS, hoặc gọi API từ ChatGPT, tất cả những hoạt động này diễn ra trơn tru với tốc độ gần như ngay lập tức. Điều này chỉ có thể xảy ra nhờ một loại trung tâm dữ liệu đặc biệt, nơi chứa hàng trăm nghìn máy chủ hoạt động liên tục, có khả năng mở rộng gần như vô hạn và được tối ưu bằng AI để vận hành tự động: Hyperscale Data Center.

Đây không chỉ là bản mở rộng của Data Center truyền thống. Hyperscale Data Center là một triết lý thiết kế hoàn toàn mới, nơi mỗi chi tiết từ mạng, lưu trữ, điện, làm mát, tự động hóa cho đến khả năng dự phòng đều được tính toán để phục vụ những khối lượng công việc khổng lồ, yêu cầu độ ổn định tuyệt đối.

Trong bài viết này, mình sẽ phân tích một cách chi tiết và mạch lạc nhất: Hyperscale Data Center là gì, chúng được thiết kế ra sao, cách hoạt động thế nào, tại sao chúng đóng vai trò cốt lõi trong kỷ nguyên AI và Cloud. Đây là bài viết ở cấp độ chuyên sâu nhưng dễ đọc, dành cho kỹ sư hệ thống, người làm cloud, người làm AI, CTO, hoặc bất kỳ ai muốn hiểu nền tảng hạ tầng hiện đại.

Hyperscale Data Center là gì?

Hyperscale Data Center là trung tâm dữ liệu quy mô cực lớn, được xây dựng để vận hành hàng chục nghìn đến hàng trăm nghìn máy chủ (server) theo mô hình phân tán (distributed computing), với khả năng mở rộng tuyến tính (linear scalability) và tự động hóa gần như tuyệt đối.

Khác với Data Center thông thường chỉ phục vụ mục đích lưu trữ, web hosting hay ứng dụng doanh nghiệp, Hyperscale Data Center được thiết kế để đáp ứng những workload đòi hỏi tài nguyên và mức độ linh hoạt khổng lồ như:

- Điện toán đám mây công cộng (AWS, Azure, Google Cloud)

- Xử lý Big Data (Hadoop, Spark)

- Đào tạo mô hình AI lớn (LLM, Vision Model)

- Phục vụ dịch vụ Internet toàn cầu (Facebook, TikTok, YouTube)

- Hàng tỷ container được triển khai hàng ngày

- Các nền tảng SaaS hạ tầng lớn

Điểm cốt lõi của Hyperscale Data Center không chỉ nằm ở quy mô, mà còn nằm ở cách nó được xây dựng: mọi thứ đều có thể mở rộng nhanh, tự phục hồi, tự điều phối, và duy trì hiệu suất dù xảy ra lỗi liên tục ở nhiều thành phần phần cứng.

Tham khảo thêm:

- Máy chủ là gì? Server là gì? Phân loại và vai trò của máy chủ server trong doanh nghiệp

- Trung tâm dữ liệu hay Data Center là gì?

Vì sao Hyperscale Data Center ra đời?

Sự bùng nổ của Internet, AI và điện toán đám mây khiến lượng dữ liệu và lưu lượng xử lý tăng theo cấp số nhân. Những Data Center truyền thống buộc phải tăng tài nguyên bằng cách nâng cấp server (Scale-Up). Nhưng scale-up chỉ phù hợp với quy mô nhỏ và vừa. Khi nhu cầu tăng lên nhiều lần, cách này lập tức trở nên không hiệu quả vì:

- Giá phần cứng cao

- Khó mở rộng đồng đều

- Khi một server mạnh bị hỏng → toàn bộ workload trên nó ngừng hoạt động

- Rất khó mở rộng theo nhu cầu linh hoạt

Do đó, thế giới cần một mô hình mới: Scale-Out.

Thay vì mua một server cực mạnh, Hyperscale Data Center thêm nhiều server giống nhau và cho chúng phối hợp qua mô hình phân tán. Chính mô hình này giúp Hyperscale có thể phát triển từ vài nghìn lên hàng trăm nghìn server một cách ổn định.

Kiến trúc tổng thể của Hyperscale Data Center

Một Hyperscale Data Center không phải là một khối thống nhất khổng lồ; nó được chia thành nhiều lớp (layers) rõ ràng. Mỗi lớp chịu trách nhiệm một nhiệm vụ và có tính độc lập cao.

Để bạn dễ hình dung, bên dưới là mô hình phân cấp của hạ tầng Hyperscale:

- Node: 1 máy chủ đơn lẻ (CPU server hoặc GPU server).

- Pod: một nhóm node (thường 48-96 server) cùng switch cục bộ.

- Cluster: nhiều pod kết nối với nhau qua kiến trúc Leaf-Spine.

- Zone: một khu vực vật lý tách biệt nguồn điện, cooling, mạng.

- Region: tập hợp 2-3 zone cách biệt nhau về địa lý.

Khi một node hỏng, workload chuyển sang node khác.

Khi một pod gặp sự cố, cluster bù đắp bằng pod khác.

Khi một zone mất điện, region vẫn duy trì dịch vụ.

Đây là lý do tại sao những nền tảng như Google, YouTube, Facebook, TikTok hay ChatGPT gần như không bao giờ “down”.

Mạng Leaf-Spine: trái tim của Hyperscale Data Center

Một trong những yếu tố quyết định hiệu suất của Hyperscale Data Center chính là mạng nội bộ (East-West traffic). Lượng dữ liệu trao đổi giữa các server trong DC lớn hơn rất nhiều so với lượng dữ liệu trao đổi giữa DC và người dùng.

Mô hình mạng truyền thống 3-tier (Core – Distribution – Access) không còn phù hợp vì gây ra tắc nghẽn. Do đó, Hyperscale sử dụng kiến trúc Leaf-Spine:

- Mỗi server kết nối vào switch Leaf

- Mỗi Leaf kết nối vào tất cả các switch Spine

- Từ server A đến server B luôn đi qua hai hop (Leaf → Spine → Leaf)

Ưu điểm của mô hình này:

- Độ trễ cực thấp

- Băng thông đồng đều

- Không choke point

- Dễ mở rộng tuyến tính bằng cách thêm Leaf/Spine mới

- Tối ưu cho distributed computing và AI training

Các hyperscaler ngày nay sử dụng đường truyền 100Gbps, 200Gbps, 400Gbps và đang chuyển sang 800Gbps.

Tham khảo thêm:

- Mạng máy tính là gì? Có những loại mô hình mạng máy tính nào?

- Thiết bị Switch là gì? Tầm quan trọng của thiết bị chuyển mạch Switch trong hệ thống mạng

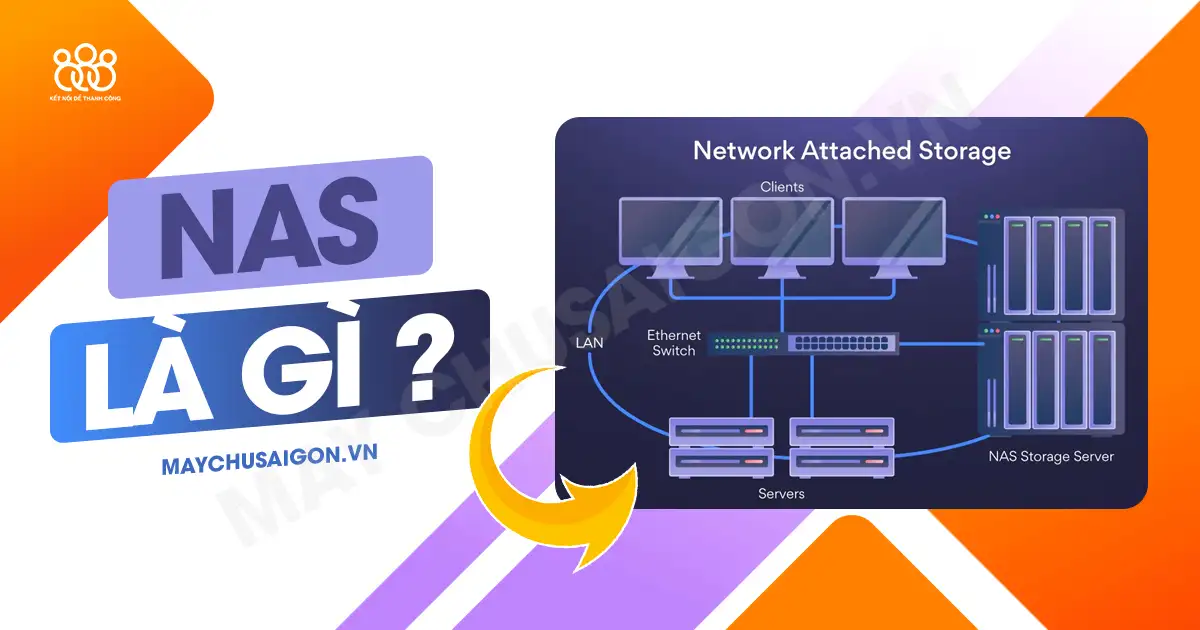

Hệ thống lưu trữ phân tán: dữ liệu không bao giờ “nằm một chỗ”

Lưu trữ trong Hyperscale Data Center không giống như lưu dữ liệu lên một server hay một SAN nội bộ. Tất cả hyperscaler đều xây dựng hệ thống lưu trữ phân tán dựa trên:

- Object Storage

- Distributed File System

- Erasure Coding

- Multi-zone Replication

Điều này có nghĩa là:

- Một file được chia ra thành nhiều mảnh nhỏ

- Mỗi mảnh được mã hóa

- Mỗi mảnh này được lưu trên nhiều server khác nhau

- Các zone khác nhau chứa bản sao dữ liệu

- Nếu một server, một rack, thậm chí một zone hỏng → không mất dữ liệu

Vì vậy, khi bạn upload video lên TikTok hoặc Google Photos, dữ liệu không nằm cố định tại một ổ cứng nào cả, nó được nhân bản thông minh và phân tán khắp DC.

Ảo hóa, container và Kubernetes: cách Hyperscale vận hành hàng triệu workload

Không có Hyperscale nào chạy workload theo kiểu truyền thống (cài đặt ứng dụng trực tiếp lên server). Mọi dịch vụ đều chạy theo mô hình:

- Máy ảo (VM) cho workload legacy

- Container cho workload linh hoạt

- Kubernetes làm hệ thống điều phối (orchestration)

Lợi ích:

- Tự động triển khai hàng nghìn container mỗi giây

- Tự động scale-in/scale-out

- Tự tối ưu tài nguyên

- Cô lập workload, giảm lỗi

- Tự phục hồi khi gặp sự cố

Đây là cách Google Search, Gmail, Facebook Feed, TikTok Feed, Netflix,… được triển khai trên hàng trăm nghìn node mỗi ngày.

Tự động hóa & AIOps: Hyperscale vận hành gần như không cần con người

Hyperscale Data Center có thể vận hành với số lượng nhân sự rất ít, nhờ vào việc:

- AI theo dõi nhiệt độ từng CPU

- AI phát hiện bất thường trong mạng

- AI tự động scale khi nhu cầu tăng

- AI dự đoán phần cứng sắp hỏng

- AI tự động route lại lưu lượng khi có sự cố

- AI tối ưu công suất điện và cooling

Những nhiệm vụ tưởng chừng cần đội ngũ kỹ sư đông đảo thì ở Hyperscale, AI xử lý gần như toàn bộ.

Cooling và năng lượng: bài toán cực khó của Hyperscale

Do mật độ server cao, Hyperscale Data Center tiêu thụ lượng điện khổng lồ. Để giảm chi phí, các hyperscaler phải phát minh những công nghệ cooling đặc biệt như:

- Làm mát ngâm (Immersion Cooling)

- Làm mát bằng chất lỏng trực tiếp (Direct Liquid Cooling)

- Làm mát bằng gió tự nhiên (Free Cooling)

- Tận dụng khí hậu như Bắc Âu, Bắc Mỹ để giảm PUE

- Dùng nước biển như Google ở Hamina, Phần Lan

- Sử dụng AI để điều chỉnh lưu lượng gió và công suất điều hòa

Một Hyperscale DC lớn có thể tiêu thụ điện bằng một thành phố 70.000-100.000 dân.

Khả năng chịu lỗi: Hyperscale không được phép “down”

Chịu lỗi là bản chất sống còn của Hyperscale. Những nền tảng như Google Search hay TikTok không thể ngừng hoạt động dù chỉ một phút. Do đó, Hyperscale DC được thiết kế để:

- Không có điểm lỗi đơn (No Single Point of Failure)

- Tất cả thành phần đều có dự phòng

- Nhiều đường điện độc lập

- Nhiều tuyến mạng độc lập

- Nhiều zone độc lập hoàn toàn

- Auto failover trong vòng mili-giây

- Auto healing khi có phần cứng lỗi

Điều này giúp Hyperscale đạt uptime 99.99% đến 99.999% (5 số 9).

Thách thức của Hyperscale Data Center

Hyperscale Data Center mang lại sức mạnh vượt trội, nhưng không phải mô hình hoàn hảo. Đằng sau quy mô khổng lồ là hàng loạt thách thức mà chỉ những tập đoàn công nghệ hàng đầu mới đủ khả năng giải quyết:

- Tiêu thụ năng lượng cực lớn: Một Hyperscale DC có thể tiêu thụ điện năng tương đương cả một thành phố nhỏ.

- Làm mát khó khăn: Mật độ tính toán cao khiến hệ thống làm mát phải đạt chuẩn tối ưu, từ giải pháp khí động học đến liquid cooling.

- Chi phí đầu tư ban đầu khổng lồ: Xây dựng một campus hyperscale đòi hỏi vốn đầu tư hàng tỷ USD.

- Bảo trì phần cứng phức tạp: Hàng chục nghìn node, ổ cứng, rack cần quy trình bảo trì chuẩn hóa và tự động hóa cao.

- Yêu cầu bảo mật nghiêm ngặt: Dữ liệu ở quy mô toàn cầu đòi hỏi tiêu chuẩn bảo mật cao, chống lại cả tấn công vật lý lẫn mạng.

- Tuân thủ pháp lý từng quốc gia: Mỗi thị trường có quy định riêng về dữ liệu, khiến việc vận hành xuyên biên giới trở nên phức tạp.

- Ảnh hưởng môi trường: Lượng điện năng và nước làm mát khổng lồ đặt ra bài toán phát triển bền vững.

Chính vì những thách thức này, chỉ một số ít công ty như Google, AWS, Microsoft, Meta mới đủ tiềm lực để xây dựng và vận hành Hyperscale DC đúng nghĩa.

Hyperscale Data Center tại Việt Nam

Tại Việt Nam, chưa có Hyperscale Data Center theo chuẩn quốc tế như Google hay AWS. Tuy nhiên, thị trường đang tiến gần hơn đến mô hình này. Những đơn vị tiên phong gồm:

- Viettel IDC

- VNPT Data

- CMC Cloud

- FPT Smart Cloud

Các doanh nghiệp này đang xây dựng Data Center theo mô hình campus, hướng đến chuẩn Tier III-IV, tích hợp công nghệ làm mát hiện đại và chuẩn hóa kiến trúc theo hướng Hyperscale. Đây là bước đi quan trọng để Việt Nam từng bước tham gia vào bản đồ hạ tầng số toàn cầu, tạo nền tảng cho AI, Cloud và Big Data trong tương lai.

Ứng dụng của Hyperscale trong kỷ nguyên AI

Sự bùng nổ của trí tuệ nhân tạo (AI) đã đưa Hyperscale Data Center lên một tầm cao mới. Những mô hình AI thế hệ hiện tại như GPT-4, Gemini, Llama, Claude chỉ có thể tồn tại nhờ nền tảng hạ tầng Hyperscale.

Các yếu tố cốt lõi bao gồm:

- Cluster GPU hàng chục nghìn card: Đáp ứng nhu cầu tính toán khổng lồ cho quá trình huấn luyện mô hình.

- Hạ tầng mạng tốc độ cực cao: Cho phép hàng chục nghìn GPU giao tiếp với độ trễ cực thấp.

- Lưu trữ băng thông lớn: Dữ liệu huấn luyện lên đến petabyte, yêu cầu hệ thống lưu trữ có khả năng đọc/ghi liên tục ở tốc độ cao.

- Hệ thống scheduling tối ưu training: Phân phối workload hợp lý, giảm thời gian huấn luyện từ nhiều tháng xuống còn vài tuần.

- Cooling mạnh cho GPU workload: GPU tạo ra lượng nhiệt khổng lồ, buộc hệ thống làm mát phải đạt chuẩn cao nhất.

- Distributed training: Huấn luyện mô hình trên nhiều node cùng lúc, đảm bảo khả năng mở rộng.

- Model parallelism và data parallelism: Chia nhỏ mô hình và dữ liệu để xử lý song song, tận dụng tối đa tài nguyên.

Nếu không có Hyperscale Data Center, thế giới sẽ không thể có những mô hình AI khổng lồ như hiện nay. Đây chính là hạ tầng nền tảng cho kỷ nguyên trí tuệ nhân tạo, nơi sức mạnh tính toán được mở rộng vô hạn để phục vụ nghiên cứu, ứng dụng và đổi mới.

>> Xem thêm: GPU là gì? Những điều cần lưu ý khi chọn mua GPU

FAQ – Một số câu hỏi thường gặp về Hyperscale Data Center

Hyperscale khác gì Data Center truyền thống?

Hyperscale vượt trội ở khả năng mở rộng tuyến tính, tự động hóa toàn diện, kiến trúc phân tán và quy mô khổng lồ. Trong khi Data Center truyền thống thường giới hạn ở một số rack và cluster nhỏ, Hyperscale có thể mở rộng đến hàng chục nghìn node mà vẫn duy trì hiệu năng ổn định.

Hyperscale có phải là Cloud không?

Không. Hyperscale là hạ tầng vật lý và kiến trúc mạng. Cloud là dịch vụ được triển khai trên nền hạ tầng đó. Nói cách khác, Cloud không thể tồn tại nếu không có Hyperscale, nhưng Hyperscale tự nó không phải là Cloud.

Doanh nghiệp SMEs có cần Hyperscale không?

Không. SMEs chỉ cần sử dụng dịch vụ Cloud được cung cấp bởi các Hyperscale DC. Việc tự xây dựng Hyperscale là không khả thi với SMEs vì chi phí và quy mô quá lớn.

Hyperscale có đắt không?

Chi phí đầu tư ban đầu cực kỳ cao, lên đến hàng tỷ USD để xây dựng một campus Hyperscale. Tuy nhiên, khi đã vận hành, chi phí tính trên mỗi workload lại rẻ hơn nhờ hiệu ứng quy mô và tự động hóa.

Có phải Hyperscale là điều kiện bắt buộc cho AI?

Đúng. Những mô hình AI khổng lồ như GPT-4, Gemini, Llama, Claude chỉ có thể train và vận hành trên hạ tầng Hyperscale. Nếu không có Hyperscale, thế giới sẽ không có AI ở quy mô hiện nay.

Lời kết

Hyperscale Data Center không chỉ là xu hướng, mà là nền tảng sống còn của toàn bộ thế giới số. Dù bạn dùng mạng xã hội, xem video, tìm kiếm thông tin, phát triển AI hay chạy ứng dụng doanh nghiệp, tất cả đều đang sử dụng sức mạnh của những Hyperscale Data Center nằm rải rác trên toàn cầu.

Nếu bạn là doanh nghiệp đang muốn nâng cấp hạ tầng, triển khai server hoặc xây dựng giải pháp hybrid cloud, Máy Chủ Sài Gòn (MCSG) hoàn toàn có thể giúp bạn lựa chọn cấu hình server, storage, networking và giải pháp phù hợp nhất theo ngân sách và nhu cầu.

Đừng ngại ngùng mà hãy liên hệ với MCSG để được hỗ trợ tư vấn hệ thống.